Az Nvidia 2004-ben, a Geforce 6800 ultra megjelenésével megjátszotta az úgy nevezett SLI technológiát, ami a felosztható PCI Express sávoknak köszönhetően, lehetővé tette, hogy egyszerre két egyforma VGA kártya legyen a számítógépünkbe, s így a teljesítményük összeadódva fog „megjelenni” számunkra! Persze az ötlet nem az Nvidiájé volt, mert hasonló megoldást még a 3DFX mutatott be a nagyközönség számára, még 1998-ban.

Az ATI is látott fantáziát a dologba, így ő is piacra a saját megoldását, 2005 szeptemberében, amit az ATI Crossfire-nek nevezett el. Az első Crossfire megoldások, eléggé elütöttek az Nvidia megoldásával szemben, illetve a manapság ismeretes Crossfire-X-el szemben!

Az első multi GPU-s ATI-s megoldásokhoz is természetesen első sorban egy Crossfire-t támogató alaplap kellett, amit eleinte ATI chipsetes alaplapok tudtak csak. Ilyen chipset volt az Ati Xpress 200 Crossfire Edition, illetve azt váltotta az Ati Xpress 3200.

De ha volt egy ilyen alaplapunk, még nem oldódott meg minden problémánk! Természetesen itt is két azonos GPU-val szerelt VGA kártya kellett, de a csavar a dologban, hogy az egyik kártyának Crossfire Master, míg a másik kártyának Crossfire Ready-nak kellett lennie!

A két kártya között a főbb különbség, hogy a Crossfire Master kártyán van egy „speciális” csatlakozó, a videó kimeneti portoknál. Erre a csatlakozóra kell rákötni a Crossfire kábel egyik végét, míg a kábel másik vége a Crossfire Ready kártya felső DVI portjára csatlakozik. Azaz a kártyákat nem a gépházon belül kell összekötni, hanem a gépházon kívül a videó kimeneti portoknál. Természetesen ehhez szükség van, egy speciális Crossfire kábelhez is.

Az ilyen módon összekötő kártyák a Radeon X800, X850 X1800XT, X1900XT, X1900XTX X1950XT és X1950XTX példányok. Tehát ezekből, a kártyákból készültek Crossfire Master, példányok.

Egy pár sort írnék arról, hogy miért ezt a megoldást választotta az ATI! Mint fentebb írtam, 2005 szeptemberében mutatkozott be a Crossfire. És hogy támogatott az X800 és X850-es széria is így, két kártyás üzemmódban. Viszont ezek a kártyák, már akkor piacon voltak, amikor a Crossfire-nek se híre, se hamva nem volt. Így tehát az ATI úgy oldotta meg, hogy a Crossfire Master kártyára, ráépített egy külön vezérlő chipet, amely a két kártya képét illeszti össze.

Ezzel a megoldással az ATI két legyet ütött egy csapásra. Egyrészt megoldotta a két kártya közötti kommunikációt, másrészt a kép összeillesztést hardveresen oldotta meg, így nem függ a szoftverektől sem a kommunikáció.

Mivel elég drága mulatság volt ez, ezért Crossfire Master kártyából sajnos elég kevés példány van kishazánkban.

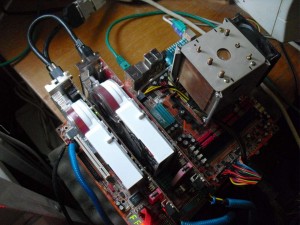

A tesztben én egy Radeon X1900XT és egy X1900XTX-et kötöttem össze. A dolog működött, mert mind a két kártyán ugyanaz az R580-as GPU kapott helyett, csak minimális órajel különbség van a kártyák között. Ilyen esetben a gyorsabb kártya a lassabb kártya órajeléhez igazodik, azaz jelen esetben egy X1900XT Crossfire-t sikerült összehozni.

Az ATI Az X1900XT-t és az X1900XTX-et egyaránt 2006 Januárjában mutatta be. A Kártyák, ahogy fentebb írtam az R580-as GPU köré épültek, ami 90nanométeres csíkszélességgel készült, s hardveresen, ahogy az egész Radeon X1000-es széria, a Directx9C-t támogatja már. A GPU mellé 512MB GDDR3-as memória lett párosítva, amely 256bites sínen tud kommunikálni a GPU-val. A GPU 16 pixel futószalagot, 16 textúrázót és 48 Pixel Shader-t kapott. ROP egységekből 16, Vertex árnyalóból pedig 8 jutott neki

Ahogy fentebb írtam az X1900XT és X1900XTX között csak is órajelbeli különbségek vannak. Míg az X1900XT 625MHz-es GPU és 725MHZ-es Memória órajelet kapott, addig az XTX társa 650MHz-es GPU és 775MHz-es memória órajellel büszkélkedhetik.

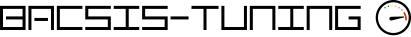

A tesztben szereplő Radeon X1900XT lett a Crossfire Master kártya, amely az Asus műhelyéből került a Prohardver szerkesztőségébe, onnan pedig pár év után az én gyűjteményemben kötött ki!

Jó Asus-os szokáshoz híven a kártya hatalmas dobozzal, és rengeteg kiegészítővel rendelkezik. Maga a kártya teljesen a referenciára építkezik, mind a NYÁK, mind pedig a hűtés szempontjából. Kimeneti portokból egy DVI portal, és magával a Crossfire csatlakozóval rendelkezik.

Az X1900XTX a Sapphire sorairól gördült le.

Itt is nyomon követhető a gyártó névjegyei, a csúcskategóriás kártya ellenére is a relatíve kicsi doboz, és a sokkal szerényebb körítés. Maga a kártya szintén referencia, viszont a hűtésen a logó már a Sapphire általi, igaz ez nagyon „gagyi” módon lett megoldva, az eredeti lógóra rá ragasztott a gyártó egy matricát a saját mintájával, ami a Ruby helyett egy idegen lényt ábrázol. Na most azért gagyi a megoldás, mert ha jól megnézitek a képet, látszik, hogy az utólag ráragasztott matrica már kezd feljönni,s alatta látható az eredeti Ruby-t ábrázoló minta.

Mivel ez a kártya Crossfire Ready példány, ezért ezen, 2 DVI port található, s a felső DVI porta kell majd kötni a Crossfire kábelt, s így csatlakozik majd a Master kártyához.

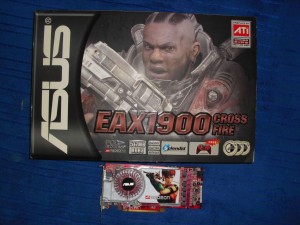

Alaplap egy Abit AT8-32X lett kiszemelve.

Ez az alaplap azon kevés lapok, közé tartozik, melyen Ati Xpress 3200 Chipset került. A lap típusszámában a 32X a VGA kártyákhoz rendelhető PCI Express sávokra utal, azaz itt kártyánként 2X16X PCI Express sáv jut. A chipset 2006 májusában debütált, és itt halkan megjegyezném, az első olyan Intel chipsetes alaplap, ami szintén natív 2X16 PCI Express sávot tudott biztosítani a VGA kártyák felé, az az X38-as chipset volt, ami csak egy évvel később, 2007-ben került piacra

És akkor egy pár szót a többi komponensről:

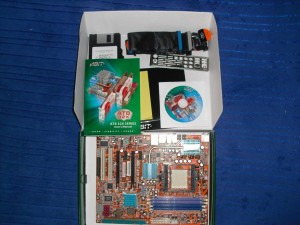

CPU-ból egy 2 magos Opteron 165-re került a választásom, aminek alap órajele nem sok, magonként 1,8GHz, viszont bitang sok tartalék lakozik benne, s a teszt alatt végig 2,92GHz-en ketyegett. Így körülbelül egy 6000+-os Athlon 64 X2 AM2-es CPU teljesítményét tudja hozni.

Memóriából 2X1GB A-Data Vitesta Extreme Edition került felhasználásra, amiknek gyári órajele 500MHz, ezt egy kicsit még megfejeltem, s a tesztek alatt 533MHz-en ketyegtek.

Akkor fussuk át, hogy is néz ki a tesztrendszer:

Abit AT8-32X alaplap

Opteron 165@2,92GHz CPU

2X1GB A-Data Vitesta 500MHz@533MHz DDR Memória

Ati Radeon X1900XT és X1900XTX VGA kártya (9.3-as Catalyst volt feltelepítve)

160GB SATA HDD

Windows XP SP3 Oprendszer.

A tesztet úgy gondoltam, hogy először lefuttatom a teszteket és a játékokat az Asus féle X1900XT VGA kártyán, majd pedig ismét lefutatom a teszteket úgy, hogy bekerült az X1900XTX is mellé, azaz a két kártya Crossfire módban futott X1900XT órajeleivel. Mindkét felállás eredményeit feljegyeztem, majd grafikonba foglaltam.

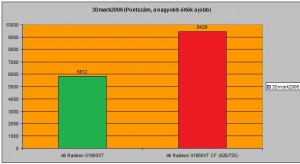

Akkor kezdjük! Nézzük meg, a kártyák mit villantanak 3Dmark 2006 alatt?

Szép kis gyorsulás, a különbség durván 80%.

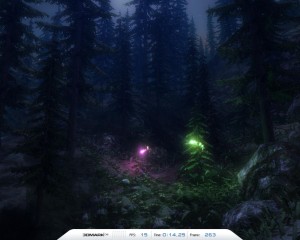

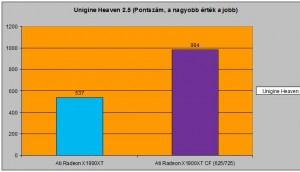

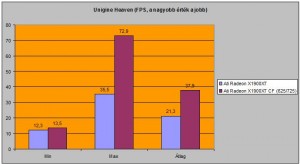

Lefuttattam az Unigine Heaven 2.5 tesztprogramot is, ami egyedül 1024X768-as felbontásban, alacsony részletesség mellett futott hibátlanul le, íme a pontszám:

Nahh, itt a gyorsulás még jobban kimutatható, laza 90%-ot hozott a Crossfire.

Mivel a program az FPS-t is kimutatja, arról is készítettem egy grafikont:

Érdekes, a legkisebb FPS szám között szinte alig van különbség, viszont a maximális FPS között több mint dupla akkora a különbség. Az átlag FPS viszont itt is kb. 80% körüli gyorsulást mutatott.

Akkor a szintetikus tesztekről ennyit, és kezdjük a játékteszteket! Minden játékot 1280X1024-es felbontásban teszteltem, a részletesség játékonként változó, de ezt minden játék grafikonja előtt fel fogom tűntetni!

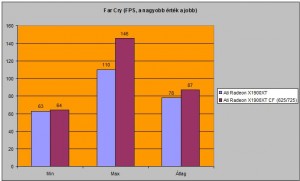

Első játékom a Far Cry nevű játék volt, ami 1280X1024-es felbontásban futott maximális részletességgel, és maximális látványjavítókkal (8X-os szűrés 8X-os élsimítás)

Itt is, mint az Unigine tesztnél, a minimális FPS szinte semmit sem, változott dupla kártyás módban sem. Viszont a maximális FPS, és az átlag FPS között már kimutatható a különbség. Bár az átlag FPS 10%-os gyorsulása nagyon szegény.

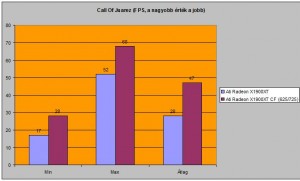

Folytatnám a sort az ATI kártyákat imádó Call Of Juarez nevű játékkal, amit szintén 1280X1024-es felbontásban futtattam maximális részletesség mellett:

Itt már szebb gyorsulás mutatható ki, hiszen átlagban a játék majd’ 60%-ot gyorsult…

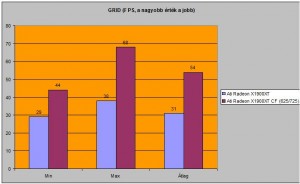

Egyet autókáztam a GRID-el is, amit most is 1280X1024-es felbontásban játszottam, maximális részletesség mellett:

Itt is körülbelül 60%-os gyorsulást sikerült kimutatni az egy és két kártyás üzemmód között.

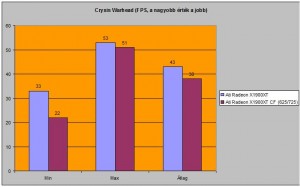

Kipróbáltam a Crysis Warhead nevű „lődözős” játékot is, ami a szokásos felbontás mellett közepes grafikai részletességgel futott:

NEM!!! Nincsenek felcserélve a grafikonok! HA a játékot Dupla GPU számolta, akkor ez esetben sebességcsökkenéssel találtam szemben magam. Sajnos nem is mérési hiba, mert kétszer is próbáltam, volt ép újraindítás, Crossfire ki/be kapcsolás, de mindig ez jött ki, hogy a Crossfire lassulást okoz. Hát ilyen is van.

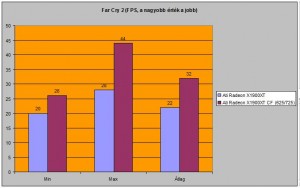

Nézzük meg a jó kis Far Cry 2 nevű játékot is! 1280X1024-es felbontás mellett High részletességet állítottam be:

Itt ismét hozott plusz FPS-t bőven a második kártya, a gyorsulás 70% körülire mutatható ki. Játékok alatt eddig ez a legjobb.

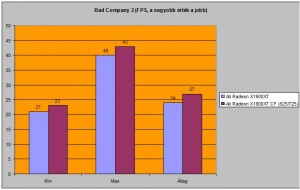

Utolsó játékom a máig igen népszerű Battlefield Bad Company 2 lett, ami a szokásos 1280-as felbontásban futott, közepes részletesség mellett:

Sajnos ennél a játéknál is némi lassulást sikerült kimérni, pedig ezt a játékot rengetegszer mértem újra, vagy 6-8 alkalommal, mert modernebb ATI(AMD) kártyák nagyon jól skálázódnak alatta, ah több GPU-t eresztek a játékra. Hát sajnos ezek az öreg bajnokok nem igazán tudtak a játékkal multi GPU-s módban mit kezdeni vele.

Lehet nem mai csirkék, de ezek (főleg számomra) csúcs kártyák. Úgy is viselkednek, mint az igazi csúcs kártyák. Azaz hangosak, melegednek, és zabálnak.

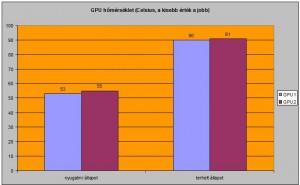

Feljegyeztem, hogy alakult a kártyák GPU hőmérséklete. Feljegyeztem a nyugalmi állapotot, amikor semmilyen 3D alkalmazás nem futott, csak a Windows „üresben járt” majd lefuttattam egy 3Dmark2006-ot s utána, feljegyeztem a legmagasabb GPU hőmérsékletet. Íme:

Nyugalmi állapotban a kártyák szép csendben voltak, és a picit több mint 50fokos hőmérséklet teljesen átlagosnak mondható, ám 3Dmark, illetve egyéb 3D-s alkalmazás alatt elkezdtek „bőgni” a ventillátorok, de így is 90fokig felkúszott a hőmérsékletük. A Ventilátor biztosan jól tette dolgát, mert a kezem a szellőzőnyíláshoz téve, éreztem, hogy tényleg már-már forró levegőt tolt ki magából mindegyik kártya.

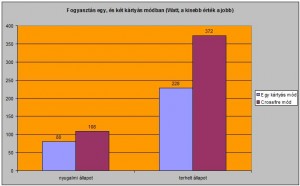

Igaz, az egy szem 6pines tápcsatlakozó manapság „alapkövetelmény” egy VGA kártyán, tehát biztosan nem eszik a két kártya annyit, mint egy GTX480-as Geforce, de azért 2 kártyás módban lehet így is el tud szállni a fogyasztás. A mérést elvégeztem egy, és két kártyás üzemmódban is. Mértem nyugalmi, és terhelt állapotot itt is. a nyugalmi állapotnál azt jegyeztem fel, mikor betöltött oprendszer, és itt is csak üresben járt a Windows. Illetve feljegyeztem a legmagasabb fogyasztást akkor, amikor futott a 3Dmark2006. Íme:

Mint látható, a nyugalmi állapotnál nincs túl sok különbség az egy és két kártyás mód között, alig 30W az eltérés, ám ha terhelésről van szó, máris 150W-al nő meg a fogyasztás, ha bent van a második Radeon.

Próbáljuk összegezni a látottakat.

Én simán vártam, hogy 80-90% körüli gyorsulást fog hozni a második kártya behelyezése, ez helyett 60-70%-os gyorsulás volt jó esetben, ráadásul volt 2 játék is, ahol nem, hogy nem gyorsult a játék, inkább lassabb lett.

Azt hittem, hogy a 2db X1900XT Crossfire-el még a nagy gépigényű játékokkal is fel lehet tolni a részletességet, mert szépen fog menni a két kártya, de ez sem jött be. Pont ahova kellett volna már a több kraft (Crysis Warhead, Bad Company 2) inkább csak lassult a játék.

Ráadásul piszok nehéz így összeválogatni manapság egy ilyen rendszerhez a hardvereket. Ritka az ATI csippes lap, ami persze kiváltható egy Crossfire-t támogató bármilyen Intel chipsetes lappal, de a Crossfire Master kártya piszok ritka, az összekötő kábelről nem beszélve. Szóval az egy dolog, hogy mai szemmel gyakorlati haszna már nincs, illetve nem éri meg/nem térül meg, de aki hobbiból, gyűjtés/birtoklás vágyból akar ilyen konfigot összerakni, hát nem lesz könnyű dolga beszerezni a hozzá való hardvereket. De legalább működik a dolog, többé-kevésbé

Bacsis-tuning Őrült hűtés és tuning megoldások bacsistól

Bacsis-tuning Őrült hűtés és tuning megoldások bacsistól

Bacsis, jó lett a teszt. Nekem attól független tetszett a dolog, hogy nem mindig hozta a teljesítményt. Az alkatrészek is elég mutatósak, szívesen birtokolnék én is egy ilyen erőművet, mutatós plexis házban ;) Ha én a dupla-kártyás üzemmódot kivitelezhetném, akkor 2db 8800GTS 512-t raknék össze Asus M2N-E SLI lappal vagy jobbal, ami tudja a 4 magos Phenomokat is. Csak ugye annyiban nem jön be a dolog mégse, hogy sokat zabál a 2 kártya, ami egyértelmű persze. De ezt eltekintve király dolog ilyen konfigot mégiscsak birtokolni ritka jó alkatrészekkel. Szal Respect teszt lett! ;)

Megint újat láttam, a korai dualRadeon összekötése is új, nekem ez kimaradt :-) Szép kis cucc, jó teszt.Az egy lassulást kivéve kb ilyenre számítottam.A lassulást valami bug okozhatja, lehet a DirectX- ben még nem számoltak az ilyen lehetőséggel, bonyolult rendszer, nem mindíg sikerül a kompatibilitás.

snk34oo! Tudod inkább akkro mit kéne? egy XFX 780i csippes alaplap Core2 Quad meg 3db 8800 ultra 3Way SLI-be.. naa az fogyasztana rendesen :-DD

DarthSun! Mint írtam, ezeknél a kártyáknál hardveresen van megoldva a két VGA kártya képének a kiszámítása/összeillesztése. ezért a directx biztosan nem szól bele hogy gyorsul-e a játék vagy nem. Éppen ezért itt régebbi játékoknál is működhet a gyorsulás, ahol elvileg ez nem lett megoldva hogy támogassa a játék az efféle képfeldolgozást…

Szóval itt valami más dolog lehet, már csak azért is, mert mind a 2 játék újabb radeonokkal piszok jól skálázódik, ha dupla kártya van a rendszerben

A szokásos alapos-kivesézős teszt. Annak idején a fél karunkat odaadtuk volna egy ilyen konfigért ám.

Valamilyen szinten függvénye volt a CF támogatás a magának a játlkprogramoknak, azért nem csak tisztán hardveres megoldás volt. Csak sok újabb programba ezeknek a régebbi CF-ek támogatását nem rakták bele, mert annyira elenyésző számú ilyen kártyatulaj volt, akinek meg mégis telt rá az már réges-régen lecserélte mire pl egy Warhead kijött.

Bacsis! Igen, gondoltam ezekre énis, csak hát nem occsó :D de majd pár év múlva, mikor lemegy az ára p3 szintre. Csak ugye még az sem biztos. Valamennyire úgyis tartani fogja az árát. A legendát meg kell fizetni, már ha lehet majd kapni.

Még, amit szeretnék birtokolni az egy core 2 quad x9xxx szériás proci.

Mennyit is fogyaszt pontosan 1 darab kártya? Mert hasonló konfiguráció-ban gondolkozom egy Gigabyte X38-DQ6-os alaplap meg 2GB DDR2@800Mhz és 2 darab Ati Radeon X1900 és még egy Intel Core 2 Duo e6600. Szerinted ehez elég lenne egy 500W-os

(2x 12Vx20A)-os táp?

Mert most, hogy fillérekbe kerül egy ilyen kártya piszkosul megéri :)!

snk34oo! Nem fog lemenni az ára/uk.. egyszerűen el fognak tűnni, teljesen kikopnak a piacról.. minden régi legendának ez lesz/lett a sorsa sajnos :-( Próbálj beszerezni egy AGP-s Geforce 6800 ultrát, avgy egy FX5950 ultrát, szitne ezeket sem lehet kapni pedig ezek még 10 évesek sinscenek még.. Még visszább menve az időbe totál eltűntek az adott kor csúcs ragadozói :-(

Radeon Fan! HA normális tápod van akkor bőven elég! terhelve nem ment a fogyasztás 230W fölé—

Bacsis! Valóban, énis erre céloztam, hogy nem lehet kapni majd.

Már pár hónapja vadászom egy 6800GT/Ultra kártyára is, találtam is múltkor 1 kottára olyan Gainwardot, mint ami neked is van, és bemutattál nemrégiben, csak akkor meg lovetta nem volt rá :@ És jelenleg van is egy 6800GT-m, 128megás, csak az valahogy mégsem olyan, mint1 ram ügyileg is behűtött – 2 táp bemenettel rendelkező 256megás példány. Mert 3D06′ markban keményen elvérzik ez 128-as példány :/ 500 és 1000 pont között. Míg egy normál GT, megkapja a 2000+ pontot. Biztos ezeknél már számít a memória mérete. Vagy csupán a DDR3 teszi különlegessé a 256megás szériákat.

nem lehetséges hogy 128bites a memória vezérlője a te 6800-asodnak? mert az simán indokolhatja hogy annyival kevesebbet nyom…

Akkor jó! A táp egy Chieftech A80 Bluk 500W

Bacsis múltkor láttam 1950XTX CFX-et és azon nem volt ilyen kábel amivel össze kell kötni,akkor az is működhetett,vagy csak jól mutatott a 2. radeon a gépben?Ja igen ezeknél a kariknál csak 2DB-ot kehet összekötni,hogy „együtt” működjenek?

Bacsis! 256 Bittes! 16/6 séder, viszont sima DDR modulos, nem DDR3-as. Azt hiszem 350MHz-es órajellel, 700 effektív. A magóra jel is 350MHz-es. Asus V9999 (kék nyákos)…

FatalEror! Az X1950XTX-eket is még így kellett összekötni.. ha nem volt rajtuk kábel, akkor az nem működött… Ezeknél a kártyáknál nem valósítható meg a CF kábel nélkül…

Itt sem használ kábelt:http://www.youtube.com/watch?v=2w3GXGrhQTg,akkor fölösleges?

úgy nem működik… belenéztem a videóba… iylen marhaságok vannak oda írva hogy 900W ttotal usage meg egyéb baromságok, jesszusom…

Na meg… nagyon nem votl demonstrálva hogy valóban hogy működött neki KÁBEL NÉLKÜL!!!!! a dolog…

talán nem véletlen?

nem… ezek a kártyák NEM MŰKÖDNEK CF-BE ÖSSZEKÖTŐ KÁBEL NÉLKÜL!!!!

xD a vidit énis megnéztem, de már aza 450+450w vicces volt :) De a lényeg nem volt bemutatva monitoron, tesztek, stb.

Bacsis,snk34oo

Köszönöm nekem is az derengett amikor megnéztem a vidit,hogy kell kábel,aztán meg már úgy voltam vele,hogy á én vagyok a hülye,mondjuk ezen a 450W-os fogyasztáson én is csak pislogtam,mert a 480 nem zabál ennyit,és ha 1KW a táp és 900W a 2db kari akkor marad 100W a 2 db HDD-nek RAM-nak CPU-nak!!!!Aminek szerintem önmagába 100W fölött van,de ebben nem vagyok biztos

Hát sajna már elpakoltam a configot, de ha nincs kábel akkor mondja hogy CF elérhető de ezt a kábelt is rá kell dugni.. szépen elmagyarázza, hogy a kábel egyik fele menjen a Master kártya CF csatijára, míg a kábel másik fele a slave kártya felső DVI portjára… ha azon volt eddig a monitor/kép akkor a kábel rádugása után a kábelen lévő DVI portra kell rádugni a monitort… tehát így frankón leírja a catalíst is hogy miről van szó, még a hüyle is megérti, nem lehet félre érteni és azért írja így le mert KELL a kábel.. de örülök hogy tisztáztuk!

A fogyasztásra visszatérve, tök egyszerű kiszámolni: a PCI Express foglalat max 75W-ot tud leadni… egy 6pines tápcsatlakozó további 75W-ot… tehát ha egy szem 6pines tápcsati van a kártyán akkro az 75+75 azaz 150W maximális fogyasztást enged… ha 2db 6pines van rajta akkor ismét egyértelmű 75+75+75… a 8pines tápcsati pedig 150W-ot tud leadni azaz ha a kártyán van egy 6pines és egy 8as akkor az alaplapi 75W a 6pinről még 75W és a 8-asról 150W tud menni a kártyának, azaz az összesen 300W tehát elméletileg egy HD2900XT vagy egy 3870X2 300W-os fogyasztást is elérHET! persze nem feltétlenül ér el ennyit… ezek az X1900XT kártyák pedig max 150W-ot tudnak bekajolni…

jó tudni ezt a 75, 150 wattos infót :)

Bacsis!

Köszönöm mester tőled mindig tanulhat az ember valami ujjat! :R

De a 900W-os fogyasztás akkor is abszurd,annak ellenére,hogy nem ismeretem a számadatokat,mert ha 750W-os tápomra az van ráírva,hogy támogatja az SLI-t és 4db 8-as VGA csati van rajta akkor biztos,hogy nem a 6800GT viszi el SLI-be hanem valami erősebbet…..De köszi az infót még egyszer respect :R