Nagy valószínűséggel mindenki hallott róla, vagy át is élte a Geforce FX szériás VGA kártyáinak a hatalmas bukását, hiszen az informatikát máig átjárja a széria bukásának a szelleme. A Geforce FX-ek hozták el az Nvidia oldalán a hardveres Directx9.0b-s támogatást a felhasználóknak, ám valójában a kártyák DX9 alatt szinte használhatatlanok voltak, annyira visszalassultak, még a legerősebb modellek is. Ám a gyűjtők nagyon sokszor nem a teljesítményt nézték az adott hardvernél, hanem egyéb különlegességeket, mint pl a gyakoriságukat, eszmei értéküket, vagy a külcsínyüket. Ilyen a tesztem egyik főszereplője, egy Leadtek A350, ami nem más, mint egy Geforce FX5900-as VGA kártya.  A kártya megjelenése igen impozánsra sikerült. Lényegében magából a NYÁK-ból és az azon lévő alkatrészekből semmit sem látunk, mert teljesen elfedi a hűtés a NYÁK mindegyik oldalát.

A kártya megjelenése igen impozánsra sikerült. Lényegében magából a NYÁK-ból és az azon lévő alkatrészekből semmit sem látunk, mert teljesen elfedi a hűtés a NYÁK mindegyik oldalát.  Az ezüst színre festett hűtés igazi eleganciát varázsol a kártyának, amit a 2, enyhén megdöntött ventillátor még jobban megfejel. Ezek a ventillátorok úgy lettek kialakítva, hogy míg az első szívja be a friss levegőt, addig a hátsó fújja ki, így igyekezvén megoldva a minél nagyobb légszálítást. A hűtés alól egyedül a molex tápcsatlakozó kandikál ki, mert hát valahol megkell táplálni a kártyát.

Az ezüst színre festett hűtés igazi eleganciát varázsol a kártyának, amit a 2, enyhén megdöntött ventillátor még jobban megfejel. Ezek a ventillátorok úgy lettek kialakítva, hogy míg az első szívja be a friss levegőt, addig a hátsó fújja ki, így igyekezvén megoldva a minél nagyobb légszálítást. A hűtés alól egyedül a molex tápcsatlakozó kandikál ki, mert hát valahol megkell táplálni a kártyát.  A kártya természetesen nem veszi fel súlyban a versneyt a mostani 2 vagy akár 3 kártya helyet felemésztő full réz hűtéses VGA kártyákkal, ám kézbe véve akkor is érezni a súlyát, hogy a hűtés nem papírból készült. A hűtés alól egyedül a molex tápcsatlakozó kandikál ki, mert hát valahol megkell táplálni a kártyát. Mint minden Geforce FX5900-as kártyákon, úgy ezen is a már NV35-ös GPU kapott helyet, ami 0,13mikronos csíkszélességgel készült, és az Nvidia oldalán, ez volt az első GPU, ami már 256bites memória buszt biztosított a minél gyorsabb adatátvitel érdekében. A GPU órajele 400MHz-re lett állítva, míg az összesen 128MB DDR RAM-ok effektív 850MHz-en ketyegnek. A GPU 4 Pixel Shader, és 3 Vertex árnyalóval lett megálldva, továbbá 4 Pipeline és 2 TMU került beépítésre. Aztán azon gondolkodtam, hogíy így önmagában letesztelni a kártyát, elég unalmas lenne, így hát kerestem mellé még egyet. Gondoltam arra is, hogy a vörös oldalról választok ellenfelet, de az ATI-s győzelem előre borítékolható lett volna, illetve némileg még feljebb a a széria létráján már egymásnak eresztettem az abszolút csúcs FX5950 Ultrát, és a Radeon 9800XT-t. Viszont eszembe jutott, hogy van nekem egy szintén még tesztelésre váró Geforce FX5800-as VGA kártyám is, ami manapság a rózsaszín holló kategóriába tartozik, így tehát úgy gondoltam, hogy jól lemérem, és indítom az FX5900 ellen. A tesztben szereplő Geforxe FX5800-as kártyát az Inno3D készítette, és teljesen a referencia dizájnt követi. Azaz pici visító ventillátor próbálja a meleget letolni a relative nagy hűtőbordáról.

A kártya természetesen nem veszi fel súlyban a versneyt a mostani 2 vagy akár 3 kártya helyet felemésztő full réz hűtéses VGA kártyákkal, ám kézbe véve akkor is érezni a súlyát, hogy a hűtés nem papírból készült. A hűtés alól egyedül a molex tápcsatlakozó kandikál ki, mert hát valahol megkell táplálni a kártyát. Mint minden Geforce FX5900-as kártyákon, úgy ezen is a már NV35-ös GPU kapott helyet, ami 0,13mikronos csíkszélességgel készült, és az Nvidia oldalán, ez volt az első GPU, ami már 256bites memória buszt biztosított a minél gyorsabb adatátvitel érdekében. A GPU órajele 400MHz-re lett állítva, míg az összesen 128MB DDR RAM-ok effektív 850MHz-en ketyegnek. A GPU 4 Pixel Shader, és 3 Vertex árnyalóval lett megálldva, továbbá 4 Pipeline és 2 TMU került beépítésre. Aztán azon gondolkodtam, hogíy így önmagában letesztelni a kártyát, elég unalmas lenne, így hát kerestem mellé még egyet. Gondoltam arra is, hogy a vörös oldalról választok ellenfelet, de az ATI-s győzelem előre borítékolható lett volna, illetve némileg még feljebb a a széria létráján már egymásnak eresztettem az abszolút csúcs FX5950 Ultrát, és a Radeon 9800XT-t. Viszont eszembe jutott, hogy van nekem egy szintén még tesztelésre váró Geforce FX5800-as VGA kártyám is, ami manapság a rózsaszín holló kategóriába tartozik, így tehát úgy gondoltam, hogy jól lemérem, és indítom az FX5900 ellen. A tesztben szereplő Geforxe FX5800-as kártyát az Inno3D készítette, és teljesen a referencia dizájnt követi. Azaz pici visító ventillátor próbálja a meleget letolni a relative nagy hűtőbordáról.

Természetesen a memóriák is kaptak hűtőbordát, s mivel azok kerültek a hátlapra is, így a NYÁK hátlapján is találunk vaskos hűtőbordát.

Természetesen a memóriák is kaptak hűtőbordát, s mivel azok kerültek a hátlapra is, így a NYÁK hátlapján is találunk vaskos hűtőbordát.  A Geforce FX5800-asról annyit kell tudni, hogy még 2003 januárjában mutatta be az Nvidia. Maga a kártya az NV30-as GPU-ra épült, ami elsőként támogatta a Directx9.0b-t. Az FX5900-tól, és az NV35-től eltérően itt a memória busz 128bites lett, ám az akkor még igen gyerekcipőben járó DDR2-es memóriákat kapott a kártya. A GPU ezt leszámítva nagyon hasonlít a korábban taglalt NV35-ös GPU-ra, azaz szintén 0,13 mikronos gyártástechnológiával készült, 4 Pixel Shader, 3 Vertex árnyaló 4 Pipeline, és 2 TMU került beépítésre. A 128MB-nyi DDR2-es memóriák effektív 800MHz-en jártak, míg a GPU 400MHz-re lett hitelesítve. Látható, hogy a kártyák között a legnagyobb eltérés a memória sávszélesség között van, hiszen hiába “csak” DDR1-es memóriákat kapott az FX5900, mégis 850MHz-en jár, s ráadásul 256biten tud kommunikálni a GPU-val, míg az FX5800-on hiába van DDR2-es memória, ha azok csak 800MHz-en járnak, s a memória busz is 128bites. Ez számokban annyit jelent, hogy az FX5800 12,8GB/sec, míg az FX5900 27,2GB/sec-es adatátviteli sebességre képes. De hogy ebből a több mint kétszeres memória sávszélességből mennyit tud pluszban profitálni az 5900-as FX, az a tesztekből most ki is derül! Elsőként a 3Dmark2001-el teszteltem a kártyákat, ami még Directx8.1-re lett kihegyezve:

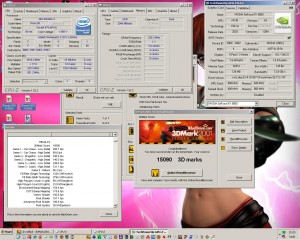

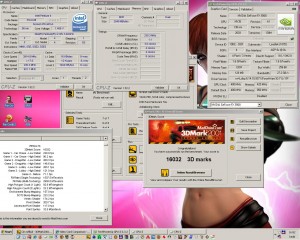

A Geforce FX5800-asról annyit kell tudni, hogy még 2003 januárjában mutatta be az Nvidia. Maga a kártya az NV30-as GPU-ra épült, ami elsőként támogatta a Directx9.0b-t. Az FX5900-tól, és az NV35-től eltérően itt a memória busz 128bites lett, ám az akkor még igen gyerekcipőben járó DDR2-es memóriákat kapott a kártya. A GPU ezt leszámítva nagyon hasonlít a korábban taglalt NV35-ös GPU-ra, azaz szintén 0,13 mikronos gyártástechnológiával készült, 4 Pixel Shader, 3 Vertex árnyaló 4 Pipeline, és 2 TMU került beépítésre. A 128MB-nyi DDR2-es memóriák effektív 800MHz-en jártak, míg a GPU 400MHz-re lett hitelesítve. Látható, hogy a kártyák között a legnagyobb eltérés a memória sávszélesség között van, hiszen hiába “csak” DDR1-es memóriákat kapott az FX5900, mégis 850MHz-en jár, s ráadásul 256biten tud kommunikálni a GPU-val, míg az FX5800-on hiába van DDR2-es memória, ha azok csak 800MHz-en járnak, s a memória busz is 128bites. Ez számokban annyit jelent, hogy az FX5800 12,8GB/sec, míg az FX5900 27,2GB/sec-es adatátviteli sebességre képes. De hogy ebből a több mint kétszeres memória sávszélességből mennyit tud pluszban profitálni az 5900-as FX, az a tesztekből most ki is derül! Elsőként a 3Dmark2001-el teszteltem a kártyákat, ami még Directx8.1-re lett kihegyezve:

Igen, itt még elég szépen húznak a kártyák, s az FX5900-as előnye mindössze csak 1 ezer pont, ami ha játékról van szó, szerintem teljesen észrevehetetlen Most pedig jöjjön a Directx9-et is használó 3Dmark2003:

Igen, itt még elég szépen húznak a kártyák, s az FX5900-as előnye mindössze csak 1 ezer pont, ami ha játékról van szó, szerintem teljesen észrevehetetlen Most pedig jöjjön a Directx9-et is használó 3Dmark2003:  Itt már némileg nagyobb a különbség az FX5900-as javára, de a 3Dmark2003-ban előszeretettel csaltak az FX-ek, így erre túl sokat nem tennék, inkább lássuk a játékokat! Az első játékom a jó öreg Far Cry volt, amit 1024X768-as felbontásban játszottam közepes részletesség mellett, íme

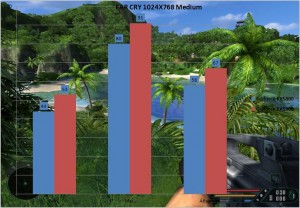

Itt már némileg nagyobb a különbség az FX5900-as javára, de a 3Dmark2003-ban előszeretettel csaltak az FX-ek, így erre túl sokat nem tennék, inkább lássuk a játékokat! Az első játékom a jó öreg Far Cry volt, amit 1024X768-as felbontásban játszottam közepes részletesség mellett, íme  Itt átlagosan 15% a különbség a két kártya között, mint korábban is írtam, ez nem olyan jelentős, hogy túlzottan megérezzük a játékok alatt, vagy hogy magasabb részletességet/felbontást kapcsolhassunk be. A tesztelést a Flatout2-vel folytattam, szintén 1024X768-as felbontásban, és maximális részletesség mellett:

Itt átlagosan 15% a különbség a két kártya között, mint korábban is írtam, ez nem olyan jelentős, hogy túlzottan megérezzük a játékok alatt, vagy hogy magasabb részletességet/felbontást kapcsolhassunk be. A tesztelést a Flatout2-vel folytattam, szintén 1024X768-as felbontásban, és maximális részletesség mellett:  A játék nagyon “feküdt” a kártyáknak, nem gondoltam volna, hogy max. részletesség mellett is ilyen szépen fog futni, igaz a szűrés ki volt kapcsolva. Ráadásul a különbség is teljesen elhanyagolható volt a 2 kártya teljesítménye között, nagyon úgy tűnik, hogy a játék nem “zabálja” a memória sávszélességet A másik kedvencem, az NFS Carbon sem maradhatott ki a tesztből, ami piszok jól skálázódik, hiszen minimumban egy Geforce3-ason is elfut szépen, de ha nagyon feltekerem a grafikát, akkor mgé egy Radeon X800-ast is megakaszt. A Geforce FX-ek mellett közepes részletességet állítottam, és most is 1024X768-as felbontást használtam:

A játék nagyon “feküdt” a kártyáknak, nem gondoltam volna, hogy max. részletesség mellett is ilyen szépen fog futni, igaz a szűrés ki volt kapcsolva. Ráadásul a különbség is teljesen elhanyagolható volt a 2 kártya teljesítménye között, nagyon úgy tűnik, hogy a játék nem “zabálja” a memória sávszélességet A másik kedvencem, az NFS Carbon sem maradhatott ki a tesztből, ami piszok jól skálázódik, hiszen minimumban egy Geforce3-ason is elfut szépen, de ha nagyon feltekerem a grafikát, akkor mgé egy Radeon X800-ast is megakaszt. A Geforce FX-ek mellett közepes részletességet állítottam, és most is 1024X768-as felbontást használtam:  Sajnos, vagy épp nem sajnos a mérésekben nincs hiba… Óriási szakadék van a 2 kártya között. De ez nem véletlen. A méréseket többször is megismételtem, s mindíg az adott kártya adott sebessége fogadott, aztán észre vettem a próbálkozásoknak köszönhetően, hogy míg az FX5900-ason DX8 módban futott a játék, addig az FX5800-ason a Directx9-es API volt használatban. Természetesen a grafikai beállításokat többször is ellenőriztem, ami mindegyik kártya esetében megegyezett, mégis ilyen érdekes anomáliába botlottam. Folytassuk a tesztet a Call Of Duty 2-vel, ahol Directx9-es API lett beállítva, közepes részletesség mellett:

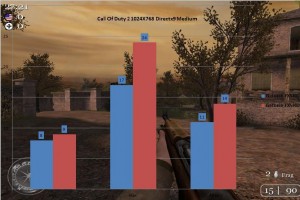

Sajnos, vagy épp nem sajnos a mérésekben nincs hiba… Óriási szakadék van a 2 kártya között. De ez nem véletlen. A méréseket többször is megismételtem, s mindíg az adott kártya adott sebessége fogadott, aztán észre vettem a próbálkozásoknak köszönhetően, hogy míg az FX5900-ason DX8 módban futott a játék, addig az FX5800-ason a Directx9-es API volt használatban. Természetesen a grafikai beállításokat többször is ellenőriztem, ami mindegyik kártya esetében megegyezett, mégis ilyen érdekes anomáliába botlottam. Folytassuk a tesztet a Call Of Duty 2-vel, ahol Directx9-es API lett beállítva, közepes részletesség mellett:  A tragikus sebeség mellett/ellenére a kártyák közti mérhető, aprócska különbség visszaállt a normális szintre. S mivel a játék Directx9-es API-ra támaszkodva szórta a pixeleket a monitorra, a tragikus sebesség már előre borítékolható volt Legutolsó játékom, ami inkább egy Benchmark volt, az a Counter Strike Source volt, amit ezúttal is 1024X768-as felbontásban futtattam, magas részletesség mellett:

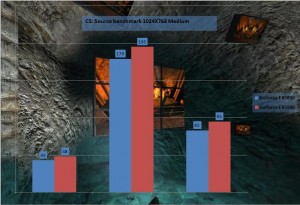

A tragikus sebeség mellett/ellenére a kártyák közti mérhető, aprócska különbség visszaállt a normális szintre. S mivel a játék Directx9-es API-ra támaszkodva szórta a pixeleket a monitorra, a tragikus sebesség már előre borítékolható volt Legutolsó játékom, ami inkább egy Benchmark volt, az a Counter Strike Source volt, amit ezúttal is 1024X768-as felbontásban futtattam, magas részletesség mellett:  A szokásos sebesség különbözet ezúttal is borítékolható volt. A kártyák nagyon szépen futtatták a tesztprogramot, ami köszönhető a Source motor remek otpimalizálásának. Összességében mit is lehetne elmondani? Azt amit eddig is tudott mindenki. Az FX széria csapnivaló teljesítményt produkál Directx9 alatt. De kérdem én! Na és? Jelenleg napjainkban nem tök mindegy? Már így is úgyis egy elavult szériáról beszélünk. Nekem viszont annál töbet ér, hogy 2 olyan kártya van a birtokomban, amik manapság nagyon ritkának számítanak, és az eszmei értékük csak növekszik szép lassan. És ha játékról van szó, a 2003-2004-es nagy nevű játékokkal még így is szépen elboldogulnak a csúcs szériás FX-ek

A szokásos sebesség különbözet ezúttal is borítékolható volt. A kártyák nagyon szépen futtatták a tesztprogramot, ami köszönhető a Source motor remek otpimalizálásának. Összességében mit is lehetne elmondani? Azt amit eddig is tudott mindenki. Az FX széria csapnivaló teljesítményt produkál Directx9 alatt. De kérdem én! Na és? Jelenleg napjainkban nem tök mindegy? Már így is úgyis egy elavult szériáról beszélünk. Nekem viszont annál töbet ér, hogy 2 olyan kártya van a birtokomban, amik manapság nagyon ritkának számítanak, és az eszmei értékük csak növekszik szép lassan. És ha játékról van szó, a 2003-2004-es nagy nevű játékokkal még így is szépen elboldogulnak a csúcs szériás FX-ek

Bacsis-tuning Őrült hűtés és tuning megoldások bacsistól

Bacsis-tuning Őrült hűtés és tuning megoldások bacsistól

Egyetértek, szép retro kártyák, nem rossz a teljesítményük sem, arra kell használni amit szépen visznek.Meg nagy érték természetesen.