Ki ne szeretné a nagy benzinzabáló V8-as motorral rendelkező hombár amerikai autókat? A többség úgy gondolom igen. Van azokban az autókban valami megfoghatatlan, valami ami rabul ejt. Aki nem (csak) az autókért rajonganak, hanem a számítógépes hardverekért, azoknak a tetemes része rajong az ex-csúcs kategóriás VGA kártyákért. S ha párhuzamot kellene hozni a benzin zabáló amerikai autók, és a 10-15 évvel ezelőtt lévő csúcs VGA kártyák között, bizony lehetne párhuzamot találni. Hiszen mindegyik zabál de nem feltétlenül megy úgy, mint egy versenyautó. Sok esetben megalomán méretek, és a spórolás jegyei semmiképp sem fedezhetőek fel.

Természetesen én is rajongok a már letűnt korok csúcs VGA kártyáikért, és ha nem is vagyok fanatikus gyűjtő, de azért egy kicsit mégis fanatikus gyűjtő vagyok. Így az elmúlt év(tized) alatt amennyire engedte a költségvetésem, igyekeztem pár ékesebb példányt beszerezni.

Ilyen az eme tesztem főszereplői is, a HD 2900XT, és a Geforce 8800 Ultra.

Ezeket a kártyákat azért is kedvelem kifejezetten, mert úgy gondolom, hogy ezek a VGA kártyák voltak a mai aktuális modern kártyáknak az első képviselő, tehát a mai modern kártyák eme cikkem főszereplőivel jelentek meg a piacon. Ez annak is köszönhető, míg korábban a GPU-k külön tartalmaztak pixel, és vertex árnyalókat, úgy addig ezeknél a kártyáknál, jelent meg elsőként az úgynevezett unfield shader rendszer, vagy magyarosabban az általános Shader rendszer, amik úgynevezett Stream processzorokat tartalmaztak, vagy ma kicsit divatosabban CUDA magoknak hívunk, igaz eleinte az Nvidia, és az AMD még némileg eltérő megoldást használt.

Fontos megjegyeznem, hogy igaziból itt beszélhetünk először hivatalosan is AMD VGA kártyákról, hiszen ez volt az első széria, ami már nem ATI néven futott, mert az ATI-t felvásárolta az AMD. Igaz, még a HD4000-es kártyák hátlapján lévő címkéken továbbra is Ati Radeon felirat szerepelt

Továbbá azért is volt óriási mérföldkő a Radeon HD 2900 XT, mert itt debütált elsőként a VLIW architektúra, amit egészen a Radeon HD 7000-es szériáig reszelgettet az AMD.

A 2007 májusában megjelent Radeon HD 2900 XT-ben 64 komplex, és 256 egyszerű Shader processzor van, tehát összesen 320db. memóriából 512MB GDDR3 került felhasználásra, ám létezik 1GB-os verzió is. És ezek a memóriák akkori szemmel nézve (és mai szemmel nézve is)döbbenetes 512bites buszon kapcsolódik az R600-as nevű, 80nanométeres csíkszélességgel készült GPU-hoz. Grafikus API-ból elsőként itt volt támogatott az AMD oldaláról a Directx 10.

A cikkem másik főszereplője a Gefoce 8800 Ultra, ami szintén 2007 májusában jelent meg. Ez a kártya lényegében nem más, mint még a 2006 novemberében megjelent Geforce 8800 GTX húzott verziója, (annyiból pontatlan a mondatom, hogy az Ultrák újabb revíziójú GPU-t kaptak, amik jobban bírták a magasabb órajelet, mint a GTX-ek)amire sokáig semmilyen válasza nem volt az AMD-nek. Amikor nagy nehezen sok-sok csúszás után piacra került a Radeon HD 2900 XT, ami messze nem hozta a tőle elvártakat, gondolta az Nvidia milyen jó kis fricska lesz, ha ő pedig kiadja a még brutálisabb teljesítményű 8800 Ultrát. Jó persze hivatalosan biztosan nem ezért került a piacra az abszolút csúcs Ultra, de én ezt a teóriát szőttem a sztori mellé. Szóval 8800 Ultra. A 90 nanométeres csíkszélességgel készült G80-as GPU 128 Stream processzort tartalmaz, amely jóval kevesebbnek tűnik mint a Radeon 320 egysége, ám itt nem volt külön bontva egyszerű, és komplex felállásra, továbbá a Stream processzorok órajele a GPU órajelének a dupláján futottak. a GPU mellé 768MB GDDR3 memória lett párosítva, ami 384 bites memória buszon tudott kommunikálni a GPU-val. grafikus API-ból ahogy a Radeonnál, úgy itt is (elsőként) lett támogatott a Directx10. Emlékszem, mikor megjelent a Geforce 8-as széria, büszkén hirdették, hogy Directx 10-es support is van, csak épp hónapokig nem volt hozzá játék, ami ezt ki is használta volna.

Fontos újítása volt még a Geforce 8800 Ultrának, hogy az Nvidia hivatalosan ezeknél a kártyáknál engedélyezte a 3 utas SLI támogatását, igaz ezt később a Geforce 8800GTX is megkapta.

Ahogy fentebb már pedzegettem, a Radeon HD 2900 XT nagyon nem váltotta be a hozzá fűzött reményeket. Eredetileg a Geforce 8800 GTX-el egy szintre várták a teljesítményét, ám valójában a 320MB-os és a 640MB-os Geforce 8800GTS-ek szintjét hozta, persze azoknál drágább volt, és brutálisan sokat is fogyasztott. A 8800 Ultra előnye behozhatatlan volt.

Ebbe a cikkbe azért vágtam bele, mert arra voltam kíváncsi, hogy vajon a korabeli játékok, és vagy a korabeli driverek (esetleges kiforratlansága) is okozhatta-e a várakozásokat alul múló teljesítményt? Így hát elővettem egy Radeon HD 2900 XT-t, és a megjelenés után 5 évvel későbbi driverrel, illetve a megjelenés utáni 5-8 évvel későbbi játékokkal leteszteltem.

Természetesen úgy teszt a teszt, ha a korábbi kihívóját is megkapják a Radeonok. Igaziból Geforce 8800 GTX lett volna a leginkább hozzáillő a 2900 XT-hez, ám abból sajnos 100%-osan működőképes egy sincs a birtokomban, pláne nem kettő. Ám 8800 Ultrából akad, így hát az került a tesztbe. S ahogy fentebb már írtam, csak órajelben tért el a 8800 Ultra és a 8800 GTX, ezért a 8800 Ultrával elvégeztem a méréseket 8800 GTX órajelekkel is.

A tesztet eredetileg úgy terveztem, hogy csavarok annyit a sztorin, és Crossfire, illetve SLI kombót is összerakok, és úgy is lemérem a kártyák teljesítményét, ám valamiért a HD2900XT-vel a Crossfire nem működött megfelelően. Sajnos több napnyi (heti?) Próbálkozásom sem vezetett sikerre. Röviden és tömören az volt a problémám, hogy a 2. kártya órajele 2D-s órajelen maradt, azaz 3D terhelés esetén sem ugrott fel. S igaz így is működött a Crossfire, de csak 50%-os hatásfokkal dolgozott, miközben tudott volna többet is. Csillió driverrel, és több HD 2900XT-vel is próbáltam, de nem jutottam előrébb. Ráadásul egyéb Crossfire konfigurációt is kipróbáltam, volt HD 2600XT, HD 3870, és HD 4870 Crossfire mérésem is, azok mind tökéletesen működtek, de a HD 2900XT csak nem akart. Így végül erről lemondtam, és egy kártyás méréseket végeztem.

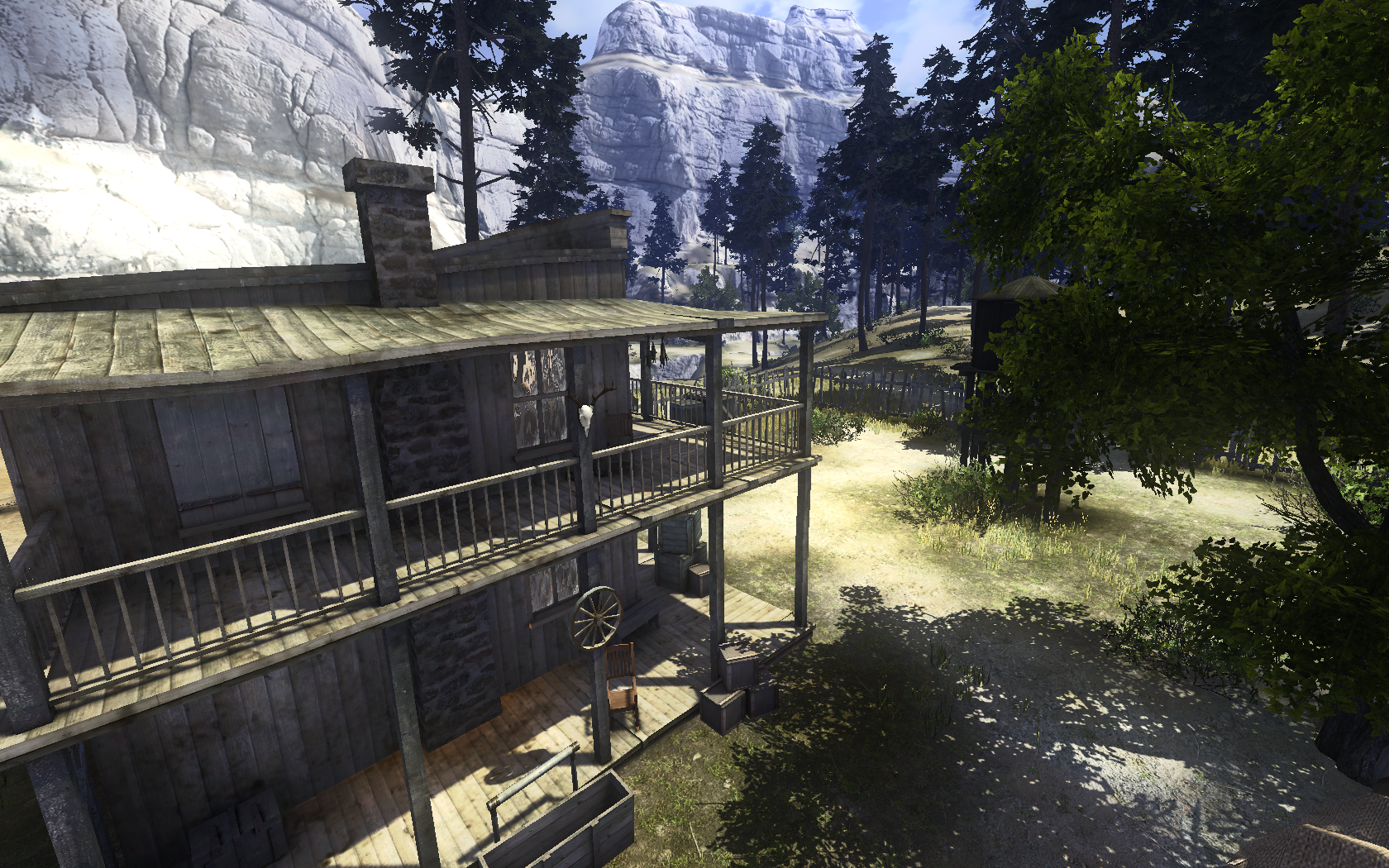

A tesztbe elég sok játékot beválogattam, a 2007-es Call Of Juarez (Dx10-es patch-el) és a 2008-as Far Cry 2 azért került be a tesztemben, mert ezek a játékok a VGA kártyákkal nagyjából egy idősek, illetve csak kicsivel újabbak. A Mafia 2 amolyan köztes pontként szerepel a régebbi, és újabb játékaim között, hiszen ez a játék 2010-ben jelent meg, illetve igyekeztem minél újabb játékokat beválogatni a tesztbe, amik még elindulnak a Radeon HD 2900 XT-n és a Geforce 8800 Ultrán egyaránt, így beválogattam a 2013-as Tomb Raider, a 2013-as Metro List Light, és a szintén 2013-as Batman: Arkham Origins-et, továbbá a már 2014-ben megjelent Grid: Autosportot. Továbbá dobpergés: mértem a kártyák teljesítményét a 2014-es Thief-el is, aminek már hivatalosan HD 4800-as, vagy Geforce GTS 250-es kártya szükségeltetik, ám mégis elindult a játék a tesztem főszereplőin.

Lássuk a tesztkonfigot:

MSI Eclipse SLI x58 alaplap

Core i7 920@4GHz CPU

4X4GB DDR3 1600MHz RAM

AMD Radeon HD 2900XT (Crossfire)+Geforce 8800 Ultra (SLI)

WD Velociraptor 150GB HDD+750GB HDD

Chieftec 750W PSU

Windows 7 SP1 x64 Oprendszer.

A teszt elkezdésekor nagy hangsúlyt fordítottam a driver kérdésre. Hivatalosan a 13.9-es (2013 Augusztusi) Legacy driver támogatja a Radeon HD 2000-es VGA kártyákat. Viszont köztudott, hogy a Legacy driverek a VGA-k teljesítményét brutálisan vissza fogja. Ezt én is tapasztaltam. Volt ahol 50%-al is lassabb volt a HD 2900 XT, mint a végül használt 11.12-es (2011 novemberi) Catalyst. Természetesen további drivereket is kipróbáltam, de azt tapasztaltam, hogy a 11.12-es a leggyorsabb, továbbá még ez az a driver, amivel a (jóval) újabb játékok is elindulnak, lásd a 2014-es Grid Autosport, vagy a Thief.

Ugyanúgy több driverrel is próbálkoztam a 8800 Ultrával, de ott nem tapasztaltam ilyen problémát, az utolsó342.08-as driverrel teszteltem végül, mert teljesítmény vesztés nélkül futottak ezzel is a játékok. Ez a driver viszont 2016 novemberi megjelenésű, tehát már itt driver téren dupla pacsi az Nvidiának, mert egyrészt nem fogta vissza a saját kártyájának a teljesítményét, másrészt fényévekkel tovább supportálta a kártyáját.

A játékok tesztjei előtt egy kis benchmarkot is futtattam, kezdjük ezekkel!

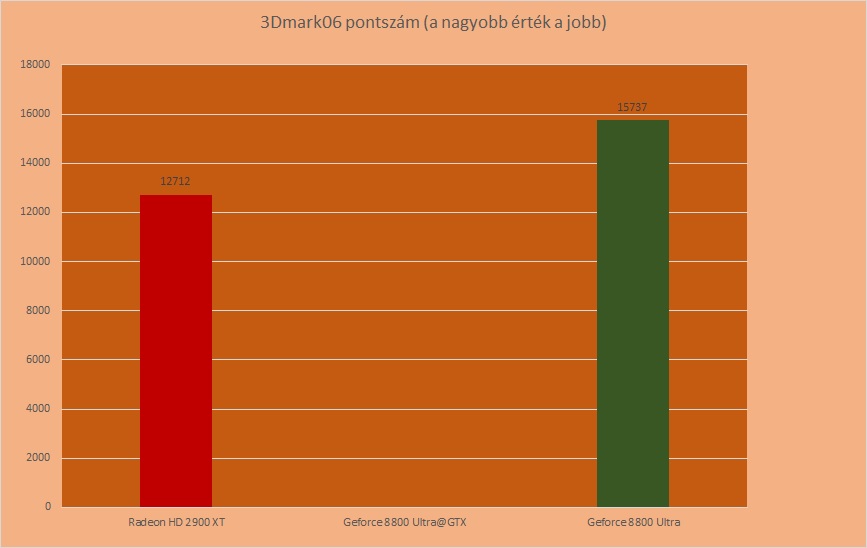

Elsőként a 3Dmark 06-ot futtattam:

Annyi anomáliába futottam, hogy amikor a 8800 Ultra órajeleit vissza fogtam, a 3Dmark06 a teszt első jelenetének a végén mindig csontra fagyott. Szóval itt még nem tudjuk meg, hogy a 8800 GTX teljesítményű Ultra hogy viszonyult volna a HD 2900 XT-hez, de az látszik, hogy a normál órajelen a 8800 Ultra nagyjából a várakozások szerint szépen ellépett. Persze ebből még ne vonjunk messze menő következtetést, hiszen a tesztprogram idősebb, mint a VGA kártyák, és hát.. csodákban még lehet hinni.

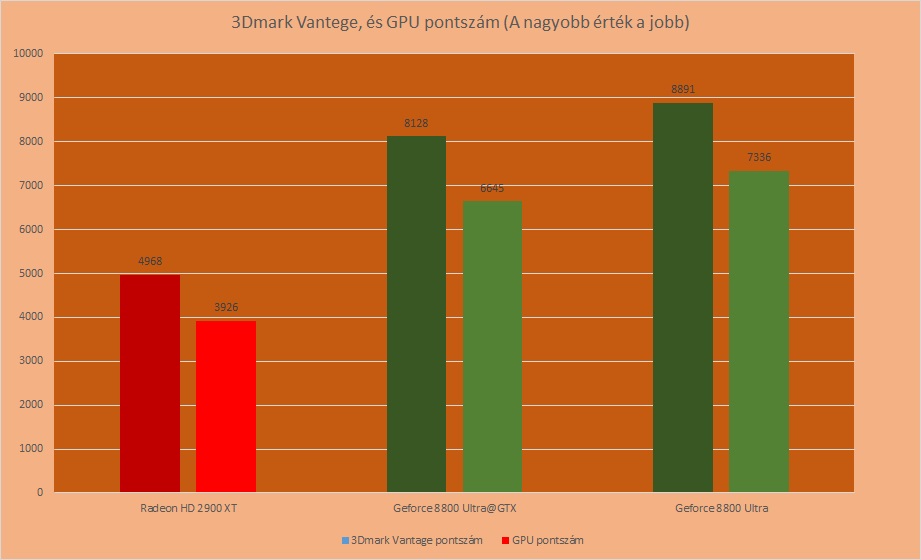

Folytassuk a tesztet a 3Dmark Vantege-vel:

Szerencsétlen HD 2900 XT valami brutális módon kikapott. Valahol számoltam vele, hogy a korabeli programokban/játékokban, frissebb driver ide vagy oda, nem túl sok babér fog teremni a Radeon számára, de hogy ennyire.

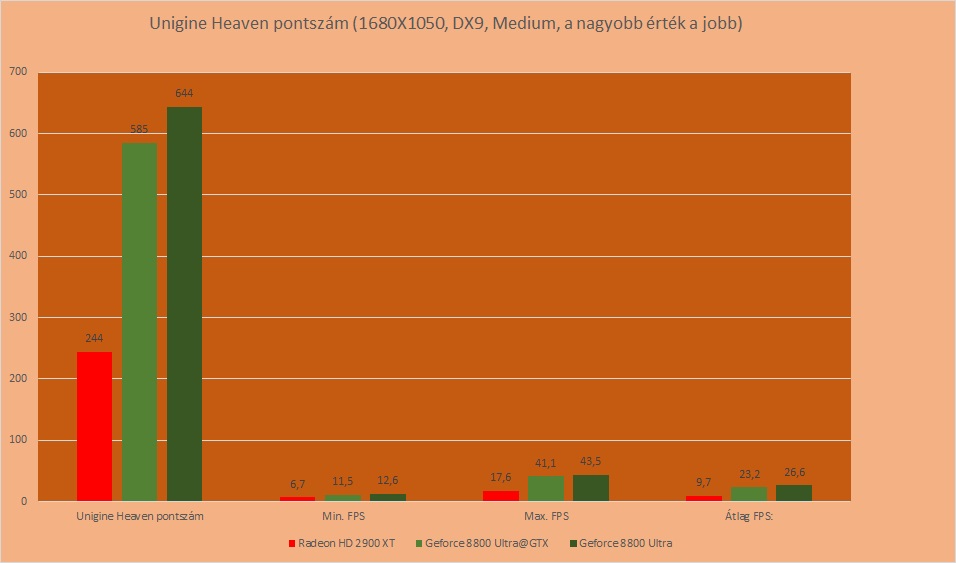

NA de lássuk Unigine Heaven benchmarkját is, azt is lefuttattam a kártyákon 1680X1050-es felbontás, Directx9-es API, és medium részletességi beállítások mellett:

Hát ez tragikus. az Nvidia teljesen más ligában játszik. Bízzunk benne, hogy a továbbiakban nem ez lesz tapasztalható, mert különben az egész teszt okafogyottá válna.

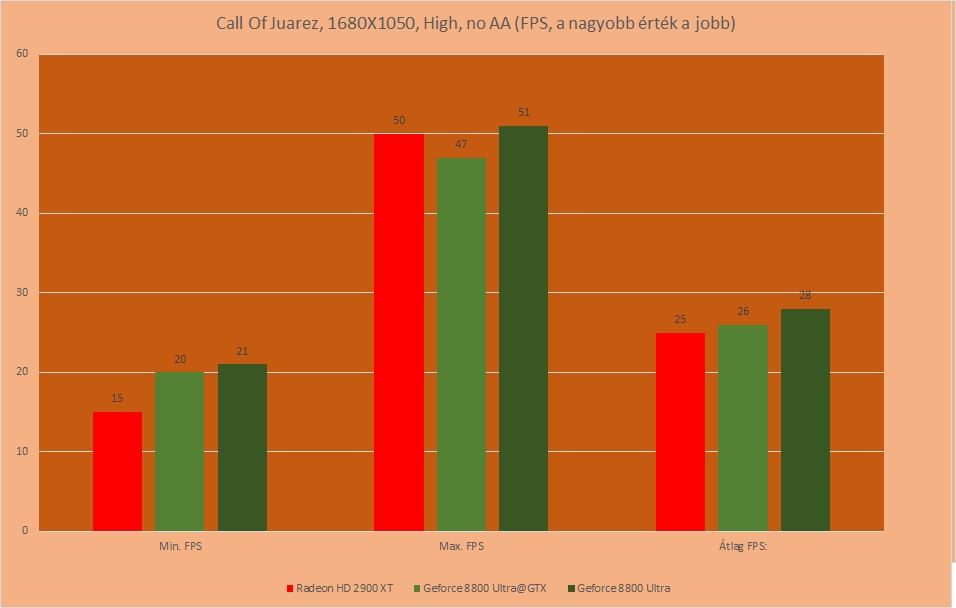

Első játékom a 2007-es, tehát a kártyákkal nagyjából egy idős Call Of Juarez volt, amire feltelepítettem a Directx10-es patchet is, amiben már van beépített benchmark is. Igaziból ez a játék azért is lett beválogatva, mert legendásan jól megy a Radeonokkal, s mivel sejthető előre, ha jól is fog szerepelni a Radeon kártya az újabb játékokban, de azt feltételezem, hogy az Ultrák nagyon el fognak húzni, akkor legalább ebben az egy játékban próbáljon a Radeon villantani. Lássuk

Itt még azt mondom hogy nagyon szépen teljesített a Radeon. Oké, a minimum FPS azért elmaradt az Nvidiától, de ennek talán az 512MB Vram volt az oka, nem magának a GPU-nak a nyers ereje, de ezt leszámítva többé-kevésbé de tartotta magát még a normál órajelen járatott 8800 Ultrával is.

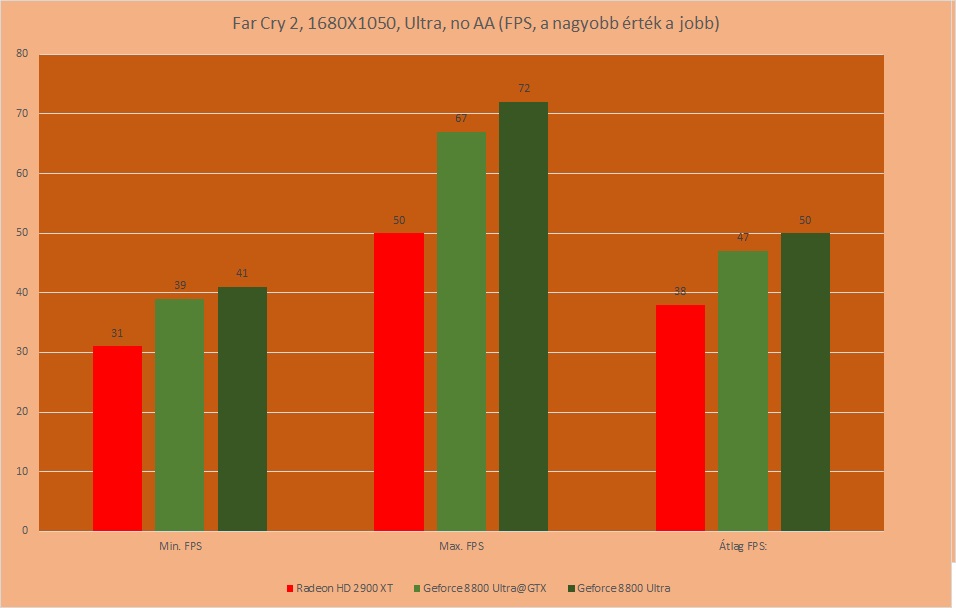

Következő játékom a 2008-as Far Cry 2, illetve annak beépített benchmarkja volt.

Itt annyival módosult a felállás, hogy inkább a minimum FPS-ek terén tudta tartani a HD 2900 a lépést a 8800-al, de a maximális FPS-ek terén a 8800 Ultra, még vissza fogva is elég csúnyán lelépte a HD 2900 XT-t.

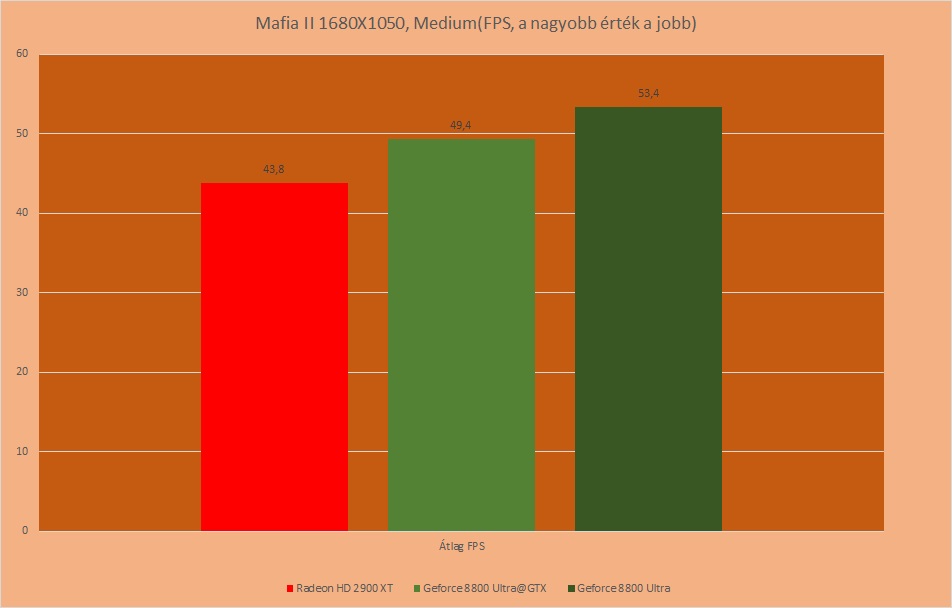

NA de nézzünk frissebb játékokat, s ugrás 2010-be, mikor megjelent a Mafia II. Annak a benchmarkjával teszteltem a kártyákat:

Sajnos itt is azt kell látni, ha nem is annyira brutálisan, de le van maradva a HD 2900, még a vissza fogott órajelű Ultrával ala’ 8800GTX-el szemben is

Ennél a játéknál csak az „átlag FPS” számot jegyeztem fel, amit a benchmark a teszt lefuttatása végén kiírt:

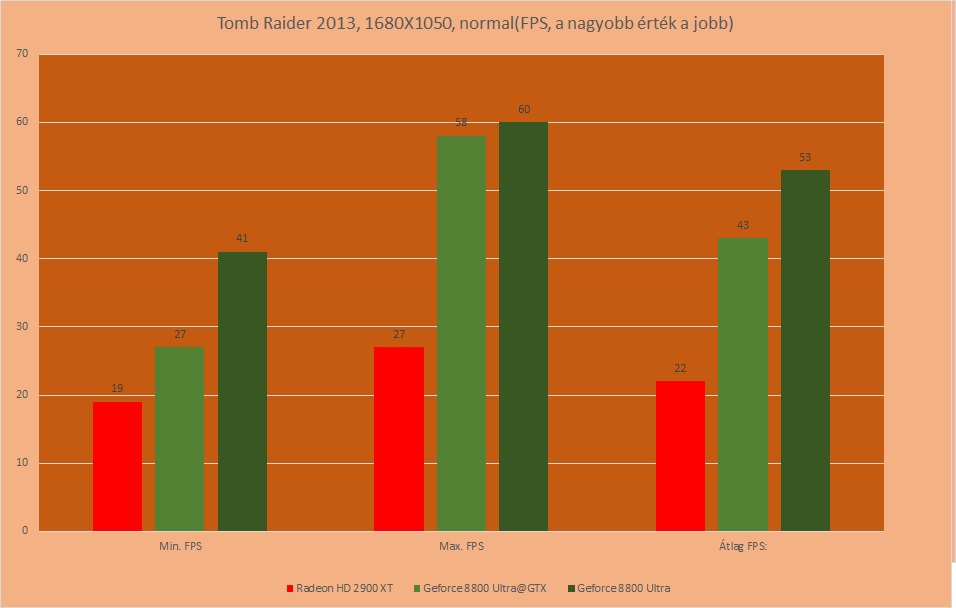

Ismét ugrottam pár évet az időben, s a 2013-as Tomb Raider benchmarkjával folytattam a tesztet:

Nagyjából a megszokott menetrend. a Radeon csúfos vereséget szenved.

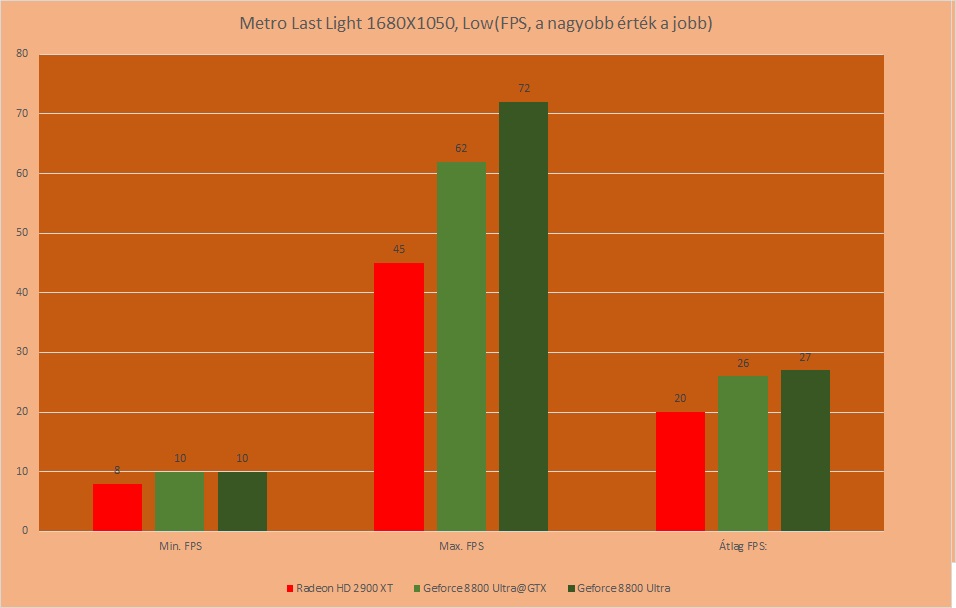

Jöjjön egy kis igazi gép gyilkoló Metro: Last Light, illetve annak a benchmarkja:

A minimum FPS-ek mindegyik kártyán csúnyán beestek. Viszont a 8800 össze tudott annyi plusz teljesítményt kaparni, hogy kevésbé legyen diavetítés a Benchmark futtatása, és sikerült 25FPS fölé kapaszkodni. A különbség viszont a maximális FPS számoknál jött ki ezúttal (is) a legjobban. Szegény Radeon itt sem bírta tartani a lépést.

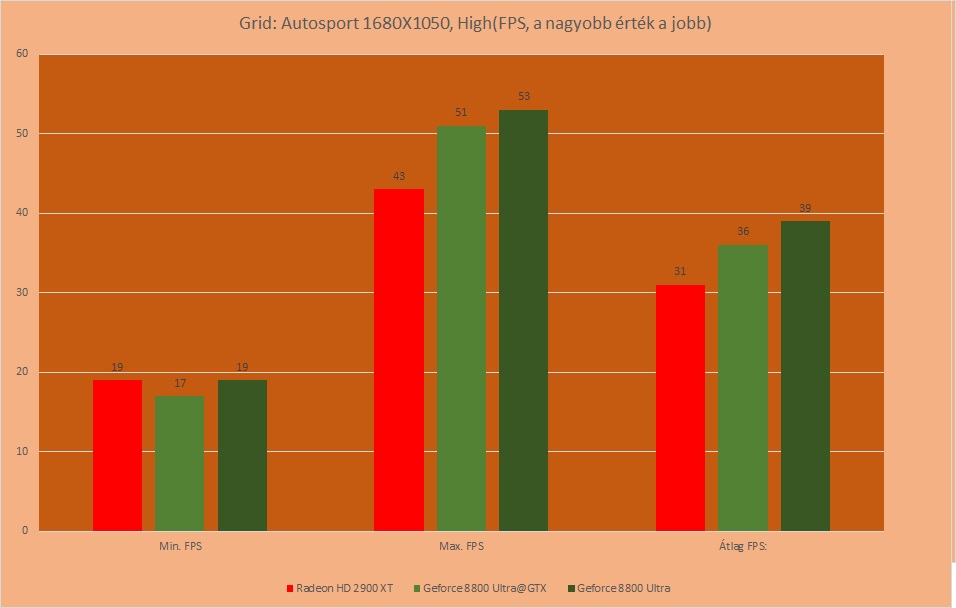

Nézzünk megint egy évvel újabb játékokat. A szuper jól optimalizált Grid Autosport következett:

A részletességet High-ra kapcsolva is aránylag elég jól futott a játék, és végre ismét a Radeon is többé-kevésbé bírta az Nvidiával a tempót. Ez főleg a minimum FPS-eknél mutatkozott meg. Azért a Maximumoknál szokás szerint lemaradt, de fentebb láttunk rosszabb eredményeket is

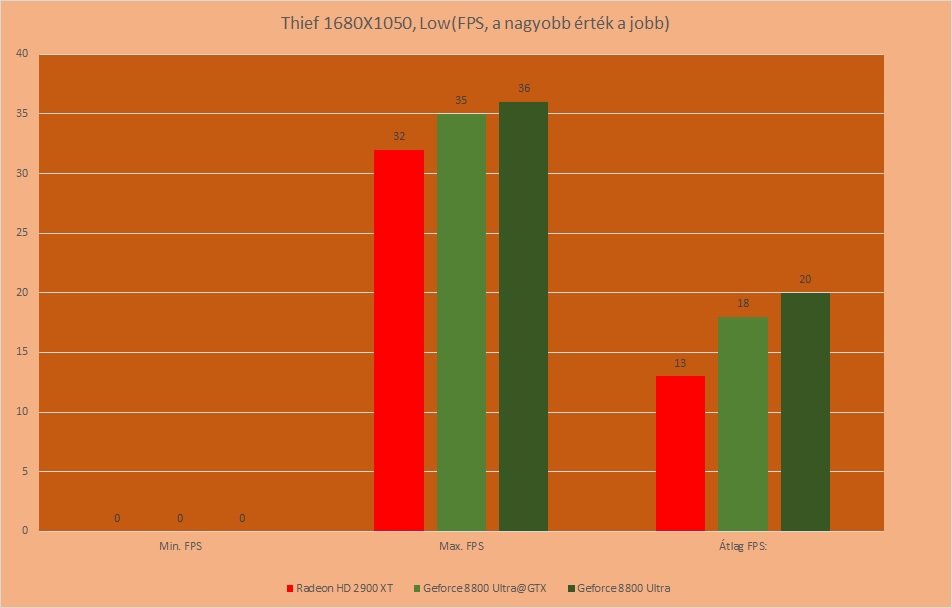

Utolsó játékom a Thief lett,

A benchmark sok esetben. ha csak egy-egy pillanatra is, de be-be szaggatott, így a minimum FPS mindegyik kártyánál 0-t mutatott. Alacsonyabb felbontás mellett azért úgy gondolom, hogy maga a játék játszhatóvá tehető… a 8800-as VGA kártyán. Ott azért még így is 20FPS körül döcögött a játék, de szegény HD 2900 mellett mindössze annyi pozitívumot tudok felhozni, hogy legalább elindult rajta a játék.

Összegzés:

Mikor megjelent a HD 2900 XT, akkor hatalmas csalódást keltett. Mindeki várta a csoda drivert. Aztán ahogy teltek múltak a hónapok, és jöttek az újabb VGA kártyák, mindegyik oldalról, a HD 2900 elég hamar feledésbe merült. Én most adtam egy utolsó esélyt, hogy háthata. De sajnos be kell látni, hogy a HD 2900 XT több szempontból is bukás lett. Nem elég, hogy a frissebb driverek, és az optimalizációk sem hozták el a várva várt teljesítmény növekedést, sajnos a gyártó elég hamar befejezte a kártya Supportálását. Oké, elvi síkon a 2013-as driverek közül is találunk olyant, ami támogatja a kártyát, s ez már 6 évvel későbbi, mint maga a VGA, de az egész nem ér semmit, ha csapni való teljesítményt tud vele a VGA kártya. Az Nvidiának ezen a szinten (is) jár a pacsi, hiszen a VGA kártya megjelenése után 9 évvel későbbi driver is támogatja. Szóval akár hogy is akarom menteni a Radeon HD 2900 XT-t, még nekem is be kell ismernem, hogy soha sem hozta azt, amit kellett volna neki

Bacsis-tuning Őrült hűtés és tuning megoldások bacsistól

Bacsis-tuning Őrült hűtés és tuning megoldások bacsistól

Szia!

A GP3 1.13 picit szaggat AMD ryzen2200g alatt,VEGA8 driver friss.A kártya a rechpowerup szerint 27%-al erősebb az itteni 8800ultranál.800×600 fölé már nem érdemes tenni, mert nem élvezhető. Pedig azt gondoltam hogy full grafikával se fog 30fps alá esni. Tippek?

Szia!

A GP4 telepítésével megoldódott a dolog,mert részletesebb grafika és nagyobb felbontás mellett is folyékony a képmozgás.

Gondolom a kód sokat frissült, Win10 alatt semmilyen komoly igazításra, állításra nem volt szükség, elsőre pöcre ment (ryzen2200g).

Azóta kaptam egy Gainward9800GT-t 512MB ddr3 rammal,amit linux mint 20.1 alatt használok.Jól fut…