Ebben a tesztemben 2 VGA kártyát szeretnék nektek tesztekkel bemutatni! Kíváncsi voltam, hogy amikor megjelent a tesztben szereplő 2 legendás kártya, a Radeon 8500, és a Geforce 3 TI500, a későbbi, kiforrott driverek után hogy viszonyulnak egymáshoz. Amikor ezek a kártyák kijöttek, és újnak számítottak, az akkori driverek, és játékokban az jött le, hogy nagyjából tényleg egy szinten van a két kártya, viszont arról is sokat lehetett olvasni, hogy a driverek kiforrásával a Radeon 8500-as ATI szépen, egyre jobban erőre kapott, és későbbiekben már a Geforce 4 Titanium kártyákkal is felvette a versenyt…

Aztán ahogy teltek a hónapok, és eljött egy újabb év, már az akkori, legújabb kártyákra helyeződött a hangsúly, és a 8500-as ATI, és a Geforce 3 TI500-as kártyák a háttérbe szorultak, pedig friss driverek még jó pár évvel később is jöttek hozzájuk, továbbá mivel abszolút csúcs kártyák voltak ezek, még a megjelenésük után 3-4 évvel későbbi játékokat is remekül vitték. De hogy a későbbi driverek segítségével, az újabb játékokkal hogy boldogultak ezek a kártyák, illetve, hogy viszonyultak egymáshoz, már nem szóltak a tesztek… Erre szeretnék most kitérni.

Természetesen a tesztek előtt ismerkedjünk meg a kártyákkal!

ATI Radeon 8500:

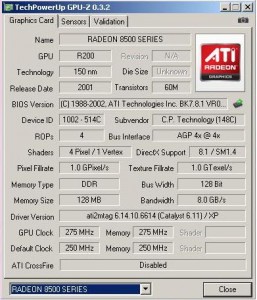

Az ATI 8500-as Radeon-t 2001-ben mutatta be, és ez volt az első Radeon, ami már támogatta a Microsoft Diretctx8.1-es API-ját. A kártya GPU-ja az R200-as kódnévre hallgat, s 150 nanométeres csíkszélességgel készült. Összesen 4 Pixel Shader, és 2 Vertex árnyaló található a GPU-ban, továbbá 8 textúrázó egység kapott még helyet. A GPU a 64 vagy 128MB-nyi össz kapacitású memóriával 128 bites buszon tud kommunikálni. A GPU órajele 275MHz, míg a memória órajele effektív 550MHz-en jár (natív 275MHz) Természetesen ezek a kártyák még masszívan AGP foglalatba passzoltak, abból is a 4X-es mód volt támogatott.

A tesztben szereplő Ati Radeon 8500-as egy Club3D gyártmányú, és teljesen a referencia felépítést használja, azaz a GPU egy picike aktív hűtést kapott, míg a memóriákon semmiféle hőleadó nincs, bár ebben az időben ez még annyira nem is volt jellemző.

Bekapcsolás után mikor megnéztem a GPU-Z segítségével kiíratott információkat:

Egyből feltűnt, hogy a kártya „csak” a 8500 LE órajelein jár, azaz a GPU 250MHz-en, míg a memória 500MHz-en járt. Érdekes, mert a kártya dobozos kiszerelésben van meg nekem, és hogy egy LE példányról lenne szó, az sem a dobozon, sem pedig a kézikönyvében nem volt feltüntetve, mindenhol „sima” 8500-as kártyaként van feltűntetve. Persze ez nem egy túl nagy gond, mert a jó öreg Rivatuner segítségével majd feljebb pöckölöm a referencia 8500-as Radeon órajeleire. A másik, ami viszont már zavaróbb volt, hogy a GPU-Z, és az Aida64 szerint is csak 1 Vertex árnyalót tartalmaz a GPU. Az interneten utánajárva mindenhol azt írják, hogy az R200-as GPU-ban 2 Vertex árnyaló van, attól függetlenül, hogy a kártya Radeon 8500-as vagy az enyhén vissza fogott 8500LE példányról van szó. Ez után még további 3db 8500-as Radeont raktam a gépbe, és mindegyikhez 1 Vertex árnyaló volt feltűntetve. GPU-Z-ből is 3 verziót próbáltam, de mindegyiknél ugyanaz volt…

Aki tudja a tényleges igazságot, ne tartsa magába, nagyon kíváncsi vagyok, hogy most ilyenkor mi van!

Nvidia Geforce3 TI500:

Az Nvidia Geforce3-as családja volt az első, ami támogatta a Directx8.0-t. Nem, ez nem elírás, míg az ATI 8500-as a Directx8.1-et támogatta, addig az Nvidia megoldása csak a 8.0-t, de ez a felhasználás szempontjából nem jelentett túl nagy különbséget. Valójában a 8.1-es Directx grafikus API könnyebben volt programozható, megjelenítésben nem volt semmi különbség a 8.1, és a 8.0 között.

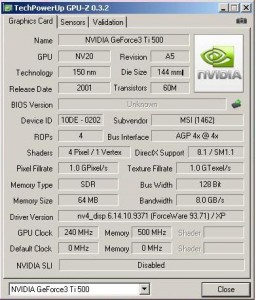

A Geforce3-as család legerősebb tagja a Ti500-as volt, ami 2001 októberében jelent meg, cirka 2 hónappal később, mint az ATI Radeon 8500-asa, és az Nvidia ezt a kártyáját is küldte az ATI Radeon 8500-as ellen. Az összes Geforce3 az NV20-as GPU-t kapta, amely mint az R200, szintén 150nanométeres csíkszélességgel készült. 4 Pixel Shadert és itt ténylegesen 1 Vertex árnyaló volt jelen a GPU-ban, továbbá itt is 8 textúrázó egységgel gazdálkodhatott a GPU. Ezek a kártyák is 64 vagy 128MB-nyi DDR memóriát kaptak, ami 128bites memóriabuszon kommunikált a GPU-val. A Kártya GPU-jának a Geforce3 TI500-as esetében 240MHz-re lett beállítva, míg a memória kerek 500MHz-re (natív 250MHz) lettek hitelesítve.

A tesztben szereplő Geforce3 TI500-as példány 64MB-nyi memóriát kapott, és a Creative gyártó készítette. Ennél a kártyánál már a memóriák is kaptak hűtőbordát, ami amúgy jellemző volt a Geforce3-as szériában. A kártya csatlakozója szintén a 4X-es AGP szabványt támogatja.

Itt is az volt az első, hogy megnéztem a kártya paramétereit a GPU-Z-ben:

Ami feltűnt, hogy SD memóriának érzékelte a program a kártya memóriáját. Ez hibás felismerés, a kártya ténylegesen DDR memóriával van szerelve. Továbbá, hogy a gyártóhoz MSI-t detektált a program. Valószínűleg a kártya korábban kapott egy BIOS frissítést, és az MSI Geforce3 TI500-as kártya BIOS-át kapta meg. Ez teljesítménybeli különbséget nem eredményez, igaziból számunkra ennek nincs jelentősége.

HA átfutjuk a két gyártó kártyájának paramétereit, látható, hogy az ATI Radeon kissé előnyben van az elméletileg 2 Vertex árnyalója miatt, illetve az órajelei is némileg magasabbak, de majd meglátjuk, hogy a valóságban hogy szerepelnek a kártyák!

Lássuk a tesztkonfigot:

Abit IC7-MAX3 alaplap

Intel Pentium4 3,4GHz@3915MHz

2X1GB Geil Ultra 400MHz@460MHz memória

ATI Radeon 8500 és Nvidia Geforce3 TI500 VGA kártya

Samsung 160GB SATA HDD

Windows XP SP3 oprendszer

Az ATI Radeon 8500-as kártya esetében a 6.11-es Catalyst-ot használtam, míg a Geforce3 TI500-as kártyánál a 93.71-es Forceware-t, ezek voltak az utolsó hivatalos driverek amik, még támogatták ezeket, a kártyákat. Végülis a kártyák megjelenése után cirka 5 évvel későbbi driverek ezek, tehát volt bőven idő, hogy minden csepp tartalék ki legyen csikarva a kártyákból

Természetesen ezúttal is szintetikus tesztekkel kezdtem a kártyákat kimérni, és már indult is a 3Dmark2001SE:

Meglepődve láttam, hogy mindegyik kártya 10ezer pont fölött kapott a 3Dmark2001-ben. Ez szerintem igen jó eredmény. A 8500-as cirka 7-8%-al gyorsabbnak tűnt ebben a tesztprogramban.

Lássuk a már inkább Directx9-re alapozó 3Dmark2003-at:

Természetesen itt voltak tesztek, amik le sem futottak a kártyákon, mert nem tudták a Directx9-es effekteket megjeleníteni. A pontszám ezért is ilyen kevés, mint amennyit kaptak!

Itt viszont, igaz ,csak egy nagyon minimális különbséggel, de az Nvidia Geforce3-asa tűnt gyorsabbnak.

Ez után arra voltam kíváncsi, hogy a kártyák mennyire bírják a túlhajtást, és úgy hogy viszonyulnak egymáshoz!

A Radeon 8500-as GPU-ját kerek 300MHz-ig bírtam emelni, míg a memóriák órajelét már csak alig tudtam feljebb rakni, 570MHz-ig mentek (natív 285MHz)

Ez a túlhajtás a GPU-nál 25MHz-et míg a memóriáknál csak elhanyagolható 10MHz-et jelent pluszban.

A Geforce3 TI500-as kártya 240MHz-es GPU-ját 265MHz-re tudtam emelni, ami szintén 25MHz, viszont a memóriák egészen 570MHz-ig bírták, ami pontosan ugyanakkora órajelet jelent, mint a 8500-as Radeon esetében.

Csak viszont ne felejtsük el, hogy ezen a kártyán a memóriák hivatalosan csak 500MHz-re lettek hitelesítve… Bár ha úgy vesszük, akkor a Radeon 8500-asán is, mert a gyári órajele a memóriáknak annál is 500MHz, csak a teszt kedvéért kapásból 550Mhz-re lett emelve.

Nahh szóval lássuk a 3Dmark2001-et így:

Ezúttal is a 8500-as Radeon nyert, ám az a kicsi különbség még kisebbre faragódott le.

És akkor most lássuk a játékokat!

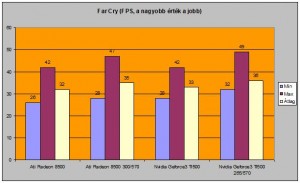

Első körben a Far Cry-al játszottam, 1024X768-as felbontásban, és közepes részletesség mellett:

Látható, hogy a két kártya szinte fej-fej mellett teljesített, talán egy hajszállal a Geforce3 volt az erősebb, de ez a minimális különbség akár mérési hibának is betudható.

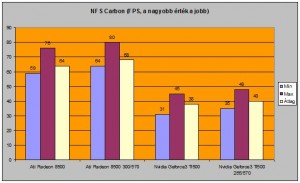

Ezután a Need For Speed Carbon-al teszteltem, most is 1024X768-as felbontásban, és közepes részletességgel:

NA itt viszont teljesen más a helyzet, mint korábban! A Radeon 8500-as közel dupla akkora teljesítményre volt képes ebben a játékban, mint az Nvidia társa. Talán itt jött ki a dupla Vertex árnyaló előnye? És akkor tényleg ott van a 2 Vertex árnyaló a 8500-asban, csak a programok nem megfelelően ismerték fel?

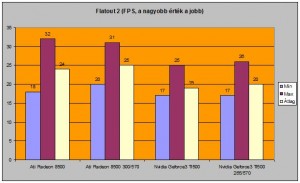

A tesztet a Flatout 2 nevű roncsderbi-s játékkal folytattam, ami ezúttal is 1024X768-ban, és közepes részletesség mellett futott:

A különbség a két kártya között ezúttal nem lett olyan hatalmas, ám az Ati Radeon 8500-ason érezhetőbben jobban ment a játék, bár még sokszor a 8500-ason is eléggé döcögős volt a játékmenet, azaz ez a játék már kifogott ezeken, a kártyákon, talán még alacsony részletesség mellett jól futott volna…

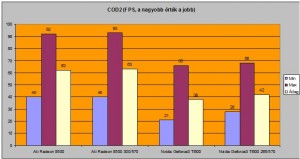

A tesztelést a legendás Call Of Duty 2-vel folytattam! A felbontás most is 1024X768-ra lett állítva, a kép renderelés Directx7-es módra lett kapcsolva, a részletesség pedig extrára:

A játék még ilyen magas részletesség mellett is gyönyörűen futott mindegyik kártyán, ám ezúttal is hatalmas szakadék lett a két kártya között, és szintén a Radeon javára.

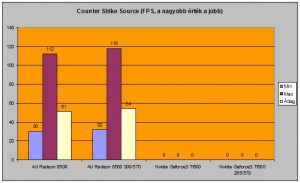

Utolsó játék, amivel teszteltem, az a Counter Strike Source, illetve a beépített benchmarkal teszteltem! A felbontás a szokásos 1024X768-ra lett állítva, míg a részletesség High-ra:

Sajnos csak az ATI kártya eredményeit tudom megmutatni, mert az Nvidia kártyával néhány textúra hibásan jelent meg, vagy fehérek voltak bizonyos objektumok, vagy szimplán eltorzult formában jelentek meg, s igaz lefutott a beépített benchmark, és még eredményt is adott, mégsem vettem be a tesztbe.

Természetesen a játék rohant a jó öreg Radeonon.

Végezetül elmondható, hogy a két kártya teljesítménye tényleg elég közel áll egymáshoz, ám az 5 tesztelt játékból 2-nél is óriási különbség volt az ATI javára, ami valószínűleg mégis csak annak tudható be, hogy 2 Vertex árnyalója van a 8500-asnak, míg a Geforce3-nak csak 1 szem. Természetesen ennek ellenére a Geforce 3 TI500-as kártya is bitang erős a maga kategóriájában. De én mégis inkább a Radeon 8500-ast választanám régi retro játékos gépbe, arról nem is beszélve, hogy míg a 8500-as Radeonok még elég gyakran előfordulnak a használt piacon, addig a Geforce3 TI500-as kártyák nagyon-nagyon ritkák.

Bacsis-tuning Őrült hűtés és tuning megoldások bacsistól

Bacsis-tuning Őrült hűtés és tuning megoldások bacsistól

Nem is gondoltam hogy a 8500-as ilyen bika volt.Jó teszt de egy QuakeIII is jó lett volna, én ahhoz jobban tudok viszonyítani.

A Quake 3 motorja közel sem tudja kiaknázni már ezeknek a kártyáknak a hardveres tudását, többek között ezért sem került bele a tesztbe :-) Igyekeztem direkt olyan játékokkal tesztelni ahol Directx8 hardveres renderelés garantált

Persze, de én csak az izomból teljesítmény miatt szoktam nézni a Quaket.

Izomból tellejsítény miatt ezekhez a kártyákhoz már inkább a Far Cry kell.. az is piszok jól skálázódik…

Radeon 4ever..

„Az Nvidia Geforce3-as családja volt az első, ami támogatta a Directx8.0-t. Nem, ez nem elírás, míg az ATI 8500-as a Directx8.1-et támogatta, addig az Nvidia megoldása csak a 8.0-t, de ez a felhasználás szempontjából nem jelentett túl nagy különbséget”

Később is elfordult már ez HD3000 vs. GF8000 (DX10.1 vs. DX10)

Vagy most is ugye.. (DX11.1 vs. DX11) :)

Bacsis! Nagyon jó lett a teszt! Mit ne mondjak, igazán meglepődtem a 8500-as Radeon-on. Kellemesen csalódtam benne! Ez a teszt egy jó terelés volt, mert terveztem venni egy GF3-ast a közeljövőben. Valószínűleg majd inkább egy ilyen Radeon-t szerzek a gyűjteménybe. Anno volt nekem egy GF3 Ti-200, 64 MB-os változat, az MX400 után. Jobbnak jobb volt, de túl sokáig sem volt élvezhető. Egy Celeron 1700 mellett, a legendás NFS Underground-ot elég siralmasan vitte. Talán egy jobb procival (P4), meg több memóriával lett volna benne még kicsavarni való. Csak ugye, akkoriban a P4-es prociknak elég borsós áruk volt. Ezért is váltottam 2800+ Barcira :)

jó teszt de azt nem értem, hogy az nem baj hogy az egyik kártya 64 míg a másik 128mb-os ez nem hoz neki valami előnyt?

Szép teszt lett, grat :)

Amin leginkább meglepődök, hogy egy mai laptop-vga (4330 80SP) is simán hozza ezen régi vasaknak az erejét. igaz 60M tranyó helyett 242M…

Max! A Memória többletkapacitás mindíg is „parasztvakítás” volt… Jó persze azért ne akarjunk 64MB VRAM-al fulHD-be játszani, de 1024X768-as felbontáshoz bőven elég a 64MB VRAM is, mint láthatod, volt hogy így is kcisivel gyorsabb volt a Geforce3 TI500 itt-ott, pedig csak fele annyi memóriája volt :-) Szóval a memória mérete SOHA nem határozza meg egy VGA kártya nyers erejét ;-)

Pontosan :)

Lásd HD 7850 1Gb vs. 2GB… sokak szerint gyorsabb a 2Gb-os, szerintem meg nem, csak szimplán több vram van mellépakolva :)

talán EGYETLEN EGY!!!!! esetbe láttam oylant hogy a Vram menynisége korlátozta magának a kártyának az össztelljesítményét, amikor kijött a 256MB-os Geforce 8800GT ill. HD3850, ezeknél HA!!!! nagyobb, értsd 1680-as felbontásba játszottál, ELŐFORDULTAK!!!! NÉHA!!! belassulások, mert kevés volt a VRAM, de kisebb azaz 1280 vagy 1440-es felbontásban még ha cinkesen is, de még oda elég votl a 256MB Vram, ezeket a kártyákat leszámítva egy esetben nem találkoztam iylennel, hogy kevés lett volna a Vram mennyiséáge…

Gratula a teszthez!

A Creative kártyát azért ismerte fel MSI-ként a GPU-Z, mert az MSI gyártott nagyon sok Creative kártyát, így kaphatott MSI BIOS-t a Creative kártya.

Lehet hogy mégse’ azért!

Most elkezdtem tesztelni egy Geforce 4 TI4600-as kártyát, és szintén ezzel a 93.71-es forceware-t raktam fel hozzá… ez egy PNY gyártmányú kártya lenne, de szintén MSI-nek ismeri fel a GPU-Z… valszeg a driverben van „valami” ami miatt így látja a GPU-Z… pedig a driver az Nvidia oldaláról van…

Jó kis teszt a régi idők emlékére :D

Ezeken a kártyákon a San Andreas elindul még?

sziasztok!

tudom hogy nem ide tartozik de az én laptopomban (asus x53br)

egy radeon 7470m van de a farcry3 csak 10-15fps-sel fut low-on! :-(

ez normális ennél a kártyánál?

mert a gépigény.hu szerint bőven elég kell hogy legyen a gép…

ha valaki tudja mi a baj az légyszives írjon.

ud00: Persze hogy megy… anno én még egy GMA950-es „csodával” ismertem meg azt a GTA részt.. és azzal is ment /épphogy/, attól meg bőven erősebbek ezek.

(COD2-nek is magasabb a gépigénye :) )

robee: Azaz oldal nem nézi pontosan hogy mi van a gépben.. a teszteket nézd, de szerintem sajnos elég reálisnak tűnik ez az eredmény

köszi a választ

kicsit szomoru vagyok…

nem baj :-)

majd a farcry1 mennifog XD

amúgy meg jó a teszt!

rég volt 286,386,486 konfig túlhajtás!

Hiába 7ezres sorozatú a kártyád, de a legalsó kategóriában foglal helyet, erre utal a 400-as szám.. ráadásul mobil, lapitopi verzió…

Far Cry 2 még talán el döcögne kellemesen, de ott is csak iylen alcsony felbontással…

Jó kis teszt grat! Anno MX440-el ilyen kártyákról csak álmodoztam :)

bacsis: azonban az nem teljesen igaz, hogy a memória soha nem határozza meg a teljesítményt (itt nem a gyártók parasztvakításaira gondolok).

Nekem egy 512MB-os GF GTS450-em van + 8GB ram a gépben. A Planetside 2 bizony 1680-ban médium-on durván meg-megakad a amikor nekivágok a bszottnagy térképnek egy repcsivel (egyébként a játék tökéletesen játszható rajta). A kártya tudna többet (high-on is simán fut ha nem vágok neki a nagyvilágnak) de a ram, erősen korlátozza ebben az esetben (másik játék a CoD Black Ops, ott is maxon be-be laggol, pedig bőven 30-40 között lenne egyébként az fps. Aida szerint is mindkét esetben a VRAM teljesen el van fogyasztva a játékok által :)

Tehát aki GTS 450-et vagy ilyen szintű kártyát akar venni, annak erősen ajánlott az 1GB-os verzió.

A videomemóriáról annyit, hogy amíg belefér minden ami kell addig mindegy, viszont ha elfogy akkor hatalmas lassulások lehetnek. Manapság a játékokban nem szoktak akkora textúrák lennni, hogy ez gond legyen(a konzolok miatt…), de például ha a Skyrimhez felteszel néhány HD textúra modot(2k és 4k textúrák), akkor FullHD mellett simán el tud fogyni 1GB VRAM és akkor van az, hogy be-beszaggat, vadon ugrál az FPS, főleg ha hirtelen megfordulsz.